※ 本記事は、Andrew Butterfieldによる”Faster large model training with NVIDIA A100 80GB Tensor Core GPU“を翻訳したものです。

2022年10月21日

NVIDIA A100 80GB Tensor Core GPUを搭載したOracle Cloud Infrastructure GM4インスタンスの開始をお知らせします。この新しいシェイプは、顧客が512 NVIDIA A100 GPUのクラスタに拡張できるOCIの高スループットで超低レイテンシRDMAクラスタ・ネットワーキングと組み合わせることで、大規模なAIモデルのトレーニングと推論の爆発的な成長を促進し続けています。

要求水準の上昇

ベア・メタルで提供されるOCI GM4インスタンスは、8つのA100 Tensor Core GPUとそれぞれ80Gの高帯域幅メモリーを備えたNVIDIA HGX A100ボードを備えており、すべてが600GB/秒でNVIDIA NVLinkによって相互接続されています。また、AMD EPYC Milanプロセッサの128個の物理コア(2.55Ghz基底周波数、3.5Ghz最大ブースト周波数、2TBのシステムRAMおよび27.2TBのローカルNVMeストレージ)を備えており、モデル・チェックポイントおよび高速ストレージ・アクセスをサポートします。

GPU当たり1時間当たり4.00ドルのシンプルでグローバルな価格設定により、お客様は以前のA100 40GBベースのインスタンスと比較して、特に単一のGPUのメモリーに収まらない大規模なモデルに対して、より優れたパフォーマンスと価格性能を期待できます。この新しいインスタンスには、前の世代よりも次の利点があります。:

- 大規模な言語モデル(LLM)、ディープ・ラーニング推奨モデル(DLRM)、コンピュータ・ビジョン(CV)のワークロードに対して最大3倍高いAIトレーニング・パフォーマンスを実現

- リアルタイムの会話型AI、製造検査、自律運転など、ワークロードのAI推論パフォーマンスを最大1.25-times向上

- 科学的なHPCアプリケーションでのパフォーマンスを最大1.8-time向上

次の表は、A100 40GBおよびA100 80GB GPUインスタンスの技術仕様と価格設定を比較しています。

| BM.GPU4.8 Eight NVIDIA A100 40 GB | BM.GPU.GM4.8 Eight NVIDIA A100 80 GB | |

|---|---|---|

| GPUメモリー | Eight GPUs, 40 GB each | Eight GPUs, 80 GB each |

| GPUメモリー帯域幅 | Eight 1.6TB/s | Eight 2 TB/s |

| CPU | Two 32c AMD EPYC Rome | Two 64c AMD EPYC Milan |

| システム・メモリー | 2 TB DDR4 | |

| Storage | Eight 6.8 TB NVMe SSDs | |

| Cluster NIC | Eight 2 x 100 Gbps NICs | |

| 価格 (per GPU/hour) | $3.05 | $4.00 |

パフォーマンスのスケール・アウト

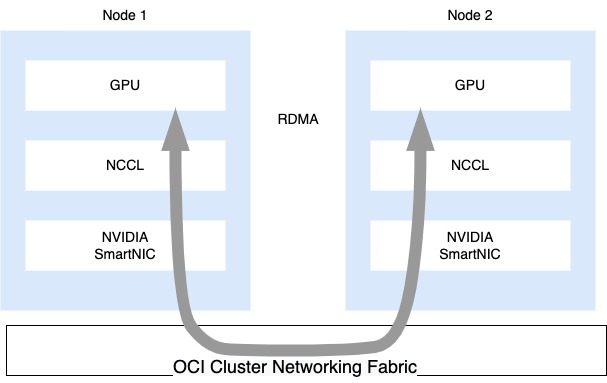

GPT3やMegatron 530-Bなどの数十億のパラメータで大規模なモデルをトレーニングしようとしているお客様の場合、BM.GPU.GM4.8ノードは、高スループットの超低レイテンシのRDMAクラスタ・ネットワーク・アーキテクチャに統合されており、現在、最大512のNVIDIA A100 GPUまで拡張できます。各BM.GPU.GM4.8ノードには、高パフォーマンスの非ブロッキング・ネットワークを介して接続された8つの2 x 100 Gbps NVIDIA ConnectX SmartNICsがあり、その結果、GPUインスタンス間で1,600 Gbpsの帯域幅が生成されます。

Adept、OCIとNVIDIAで強力なAIトレーニング・モデルを構築

機械学習の研究および製品ラボAdeptは、OCIおよびNVIDIAテクノロジを使用して、コンピュータまたはインターネット上でユーザーが実行する様々なタスクを実行できるユニバーサルAIチームメイトを開発しています。NVIDIA A100 80GB GPUのクラスタで実行され、OCIの高ネットワーク帯域幅を活用することで、Adeptは大規模な人工知能(AI)および機械学習(ML)モデルを以前よりも迅速かつ経済的にトレーニングできます。その結果、Adeptは、一般的なインテリジェンス・ロードマップを迅速に推進し、最初の製品を開発できるようになりました。これは、ナレッジ・ワーカーが毎日使用するツールの生産性と創造性を可能にする豊富な言語インタフェースです。

はじめに

NVIDIA A100 80GB GPUを追加すると、発表されたA10 GPUを含むOCI上のNVIDIA GPUの既存のラインアップが補完され、OCI上の世界中のスタートアップ、企業、政府向けの高速コンピューティングの新しい時代が始まります。すべてのワークロードが同じであるとは限りません。また、最新世代のGPUハードウェアで最適に動作するためにカスタマイズが必要な場合もあります。OCIでは、ワークロードを稼働させるためのテクニカル・サポートが提供されるため、詳細については営業担当者にお問い合せください。

仕様、価格設定および可用性を含むBM.GPU.GM4.8インスタンスの詳細は、ドキュメントを参照してください。Oracle Cloud Infrastructureの機能の詳細は、次のリソースを参照してください。: