※ 本記事は、Niranjan Mohapatra, Somnath Lahiri, Sadra Fardhosseiniによる”Empower generative AI inference performance using NVIDIA NIM on OCI“を翻訳したものです。

2024年10月25日

生成AI(GenAI)推論とは、トレーニング済みの生成人工知能モデルを使用して、新しい入力データに基づいて出力または予測を生成するプロセスを指します。この推論フェーズでは、モデルはトレーニング中に学習した内容を適用して、テキスト、イメージ、その他のタイプのデータなどの結果を生成します。適切な推論エンジンを選択することは、入力データを処理し、正確な予測とリアルタイムの応答を効率的に生成するために重要です。効果的な推論により、モデルでは大量のリクエストを迅速かつ大規模に処理できます。これは、リアルタイムの応答を必要とするアプリケーションや、検索エンジンやインタラクティブなAIアシスタントなどの高スループットを必要とするアプリケーションに不可欠です。

正しい推論エンジンの選び方

GenAIワークロードに適した推論エンジンを選択する際には、効率性、スケーラビリティ、ビジネス価値、デプロイメントの複雑さ、メンテナンス、推論エンジンの管理、タイムリーなテクニカル・サポートの必要性など、いくつかの要因を考慮する必要があります。ただし、企業は主に、トークン当たりのコストで測定される総所有コスト(TCO)と、最初のトークン(TTFT)とトークン間待機時間(ITL)で評価されるエンド・ユーザー・エクスペリエンスの2つの重要な側面に重点を置いています。この複雑なトレードオフに対処するために、オラクルは主要なオープンソース推論エンジンとNVIDIA NIMマイクロサービスを使用してパフォーマンス・ベンチマークを実行しました。

NVIDIA NIMの紹介

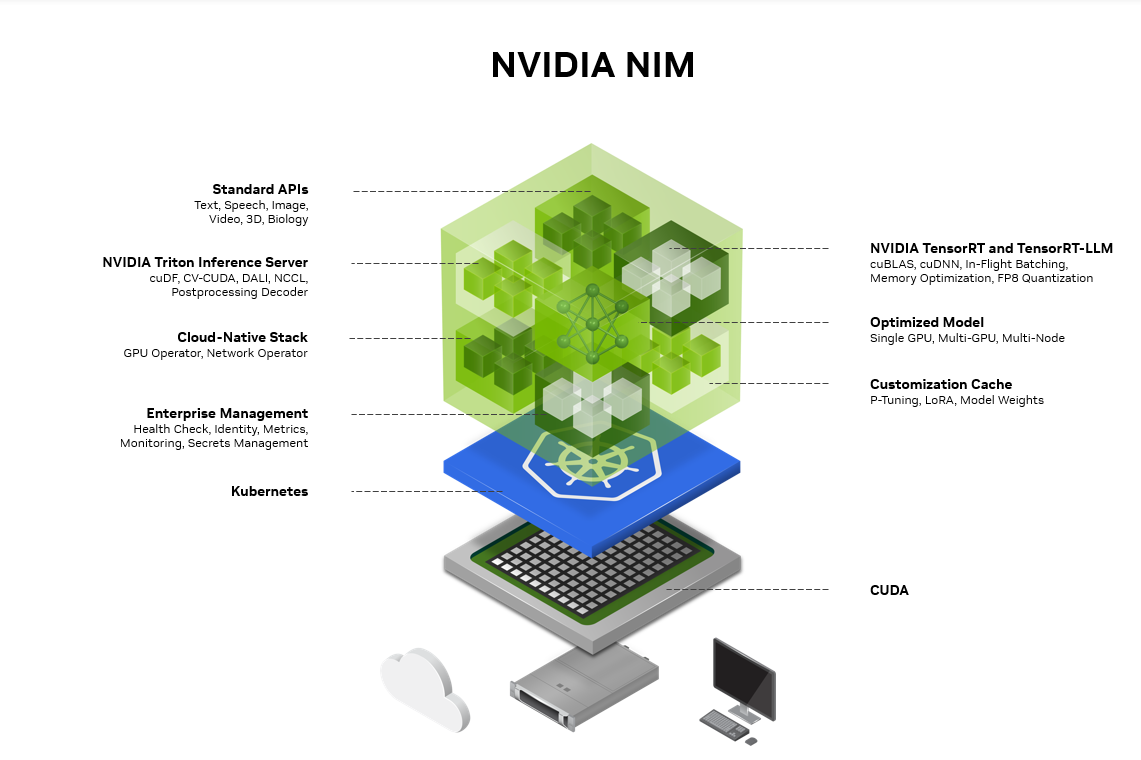

NVIDIA AI Enterpriseソフトウェア・プラットフォームの一部であるNVIDIA NIMは、クラウド、データ・センター、ワークステーション全体にわたる高性能AIモデル推論の安全で信頼性の高い導入を実現するために設計された、使いやすいマイクロサービスのセットです。オープンソース・モデルやNVIDIA AI Foundationモデルなど、幅広いAIモデルをサポートしているため、オンプレミスやクラウドで、シームレスでスケーラブルなAI推論が可能になり、業界標準のAPIを活用できます。

NVIDIA NIMは、GenAI開発の複雑な世界とエンタープライズ環境の運用ニーズとのギャップを埋めるように設計されています。この設計により、企業内のAIの変革に貢献できるエンタープライズ・アプリケーション開発者の数が大幅に増え、将来的にさらに成長する可能性があります。

OCIでNVIDIA NIMを使用する理由

Oracle Cloud Infrastructure (OCI)は、そのクラスの最初のパブリック・クラウドで、あらゆるアプリケーションのプラットフォームとして最高に優れています。お客様は、クラウド・ワークロードにOCIを選択することが増えており、そのメリットは数多くあります。OCIは、NVIDIA NIMの実行に最適化されたNVIDIA GPUアクセラレーテッド・ベア・メタルおよび仮想マシン(VM)コンピュート・シェイプを提供し、他のクラウド・プロバイダと比較して優れたパフォーマンスと管理の容易性を実現します。Oracleは、多くの企業が様々なアプリケーションに使用し、データをOCIストレージに安全に格納する、世界クラスのデータベース・ソリューションも提供しています。OCIデータベース製品間の柔軟なネットワーク接続により、お客様は、このデータをシームレスに使用して、大規模言語モデル(LLM)をトレーニングまたはファインチューニングしたり、検索拡張生成(RAG)ワークフローのために直接接続したりできます。

[OCIへのNVIDIA NIMによる生成AIの即時デプロイ (youtube.com)]

開発者向けのNIMベンチマーク

NVIDIA NIMとオープンソースの推論エンジンを、環境設定、コンテナの導入、LLM推論性能の比較、サポートの評価の分野で比較しました。これらの側面に基づいて、NIMはオープンソースの推論エンジンと比較して優れた開発者エクスペリエンスを提供すると結論付けました。次の項では、NVIDIA NIMとオープンソース推論エンジンのパフォーマンス比較の例を示します。

パフォーマンス比較

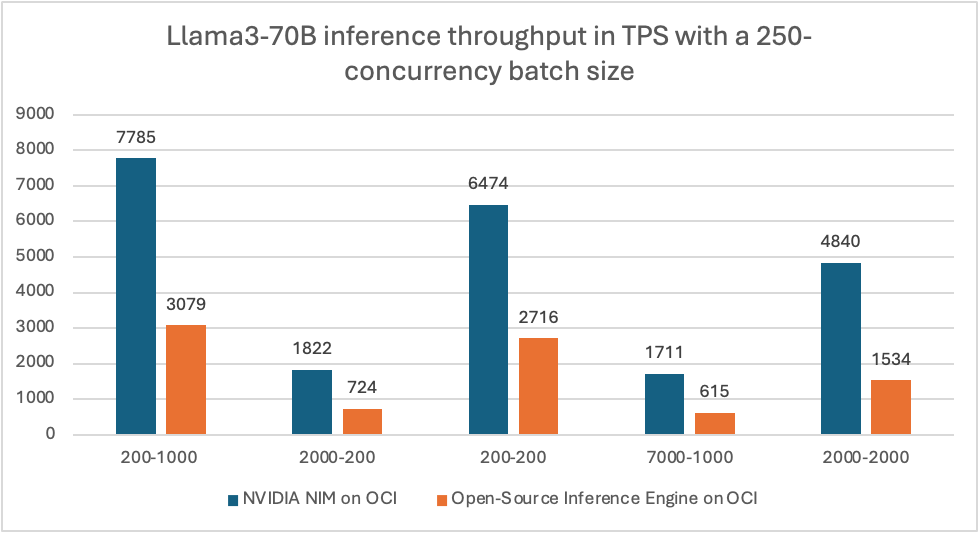

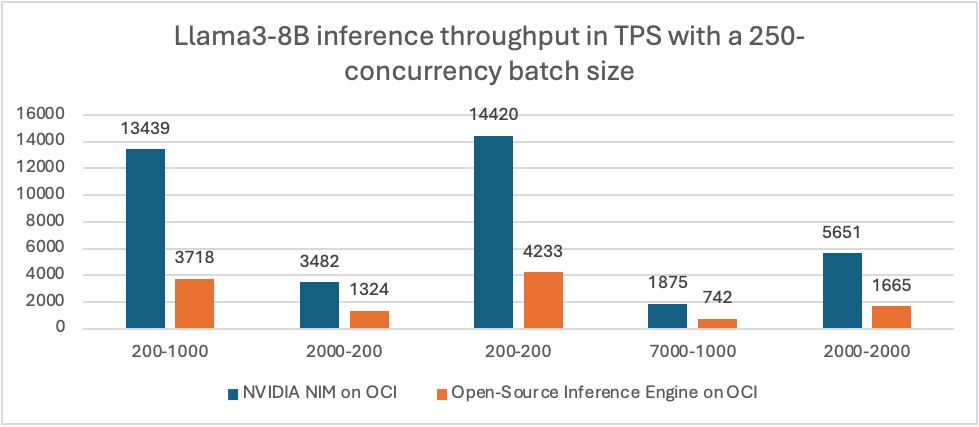

NVIDIA NIMとオープンソースの推論エンジンを評価し、どちらもNVIDIA H100 Tensor Core GPUを搭載したOCI Computeホストで実行され、パフォーマンス・ベンチマークを実施しました。大規模言語モデル (LLM) Llama 3-8B (中小LLMワークロード)とLlama 3-70B (大規模LLMワークロード)を用いました。この比較では、毎秒トークンのスループット、トークン間の待機時間、および異なるバッチ・サイズ、入力トークンの数、出力トークンの数にまたがる最初のトークンの時間に焦点を当てました。

その結果、NVIDIA NIMの推論性能は、様々なシナリオでオープンソース推論エンジンの推論性能より1.5倍から3.7倍優れていることが分かりました。また、中規模から大規模の企業で一般的な高同時性バッチ・サイズを使用する場合、オープンソースの推論エンジンと比較して、2回以上NIMのパフォーマンスが大幅に向上しました。このパフォーマンス向上は、テキスト生成および翻訳のユースケースで特に顕著です。また、NIMは、多数のパラメータを持つモデル・サイズが大きいオープンソースの推論エンジンを常に上回ります。

次のグラフは、NVIDIA NIMとオープンソース推論エンジンのパフォーマンス比較の例を示しています。1秒当たりの合計トークン数(TPS)と、入力および出力トークン・サイズを比較しました。

まとめ

NVIDIA NIMは、OCIへの生成AIモデルの導入を加速します。最新のLLMのパワーをエンタープライズ・アプリケーションにもたらし、高度な自然言語処理(NLP)と理解機能を提供します。企業は、Oracle Cloud Infrastructureベア・メタル・コンピュート・インスタンスでNIMコンテナを実行して、強化されたパフォーマンスを活用できます。OracleまたはNVIDIAに連絡して、OCI上のNVIDIA NIMの詳細を知ることができます。

NVIDIA NIMとOCIの詳細

https://blogs.oracle.com/cloud-infrastructure/post/dbrx-llms-oci-nvidia-nim-delta-sharing

https://blogs.oracle.com/ai-and-datascience/post/nvidia-nim-oci

https://blogs.oracle.com/cloud-infrastructure/post/agentic-workflow-oci-using-nvidia-nim

https://blogs.nvidia.com/blog/oracle-cloud-infrastructure-ai-gpu-digital-twins/

https://www.oracle.com/jp/artificial-intelligence/scale-nvidia-nim-inference/