※ 本記事は、Akshai Parthasarathy, Sagar Zanwarによる”New to OCI AI Infrastructure: Midrange Bare Metal Compute with NVIDIA L40S and VMs with NVIDIA H100/A100“を翻訳したものです。

2024年8月26日

Oracleは、最先端のインフラストラクチャを構築してきた歴史があります。15年以上前に、Exadata v1でRDMAベースのクラスタ・ネットワーキングを先駆けました。2016年には、ハイパースケーラ間でベア・メタル・コンピュート・シェイプを導入しました。

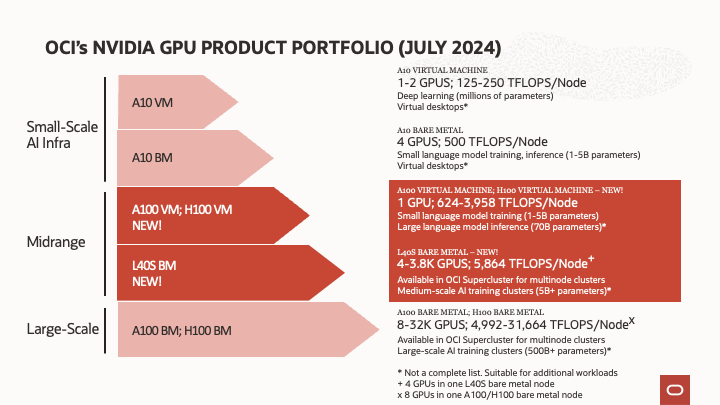

当社は、数万のNVIDIA A100およびH100 Tensor Core GPU向けに、OCI Superclusterで最大のAIクラスタを支えています。また、1から4個のNVIDIA A10 Tensor Core GPUを搭載した単一ノードで、小規模な仮想デスクトップ、AI推論、AIトレーニング・ワークロードを有効にできました。ただし、中規模のAIトレーニングおよび推論のために、非常に小規模から非常に大規模なデプロイメントまで、エンタープライズ・ユース・ケースで満たす必要のあるギャップがありました。

私たちが発表する2つの新しいシェイプは次のとおりです:

- BM.GPU.L40S.4、「L40S Bare Metal:」は、OCI Superclusterで最大3,840個のGPUをサポートし、NVIDIA L40S GPU当たり1,466個のTFLOPSをサポートします。

- VM.GPU.A100.1およびVM.GPU.H100.1、「A100 VM」および「H100 VM」はそれぞれ、NVIDIA H100 GPU当たり最大3,958 TFLOPSのVMフォーム・ファクタで単一のGPUをサポートします。

4つのNVIDIA L40S GPUを搭載したOCIベアメタル・コンピュート

今日注文可能—BM.GPU.L40S.4ベア・メタル・コンピュート・シェイプは、4つのNVIDIA L40S GPUを備えており、それぞれに48GBのGDDR6メモリーがあります。このシェイプには、7.38TB容量のローカルNVMeドライブ、112コアを搭載した第4世代Intel Xeon CPU、および1TBのシステム・メモリーが含まれます。また、OCIは、パブリック・クラウドのハイパースケーラーの中で、ベア・メタル・シェイプに最適なオプションを提供しています。これらのシェイプにより、高スループットおよびレイテンシの影響を受けやすいAI/MLワークロードの仮想化のオーバーヘッドが排除されます。コンピュート・シェイプの高速化は、NVIDIA Bluefield-3 DPUを備えており、サーバーの効率性を向上させ、データ・センター・タスクをCPUからオフロードして、ネットワーク、ストレージおよびセキュリティのワークロードを高速化します。NVIDIA Bluefield-3 DPUの使用は、OCIのオフボックス仮想化戦略をフリート全体にわたってサポートしています。

OCI Superclusterの超低レイテンシ・ネットワーキングは、NVIDIA L40Sと組み合わせて、ミッドレンジのスケーラビリティでのLLMのトレーニングと推論を行います。OCIのクラスタ・ネットワークは、NVIDIA ConnectX RDMA NIC上にRDMA over Converged Ethernet Version 2 (RoCE v2)を使用して、高スループットでレイテンシの影響を受けやすいワークロードをサポートします。BM.GPU.L40S.4インスタンスは、4つのNVIDIA L40S GPUを持つスタンドアロン仮想ワークステーションとしても使用できます。これらのミッドレンジクラスタは、次に示すように、800 Gb/秒のノード間帯域幅でサポートされます。

NVIDIA A10、NVIDIA L40S、NVIDIA H100 GPUのOCIシェイプの比較

|

|

BM.GPU.A10.4 |

BM.GPU.L40S.4 (New) |

BM.GPU.H100.8 |

| Form factor |

Bare metal |

Bare metal |

Bare metal |

| Hourly price ($ per GPU) |

$2 |

$3.50 |

$10 |

| Performance (TFLOPS)* |

250 1x |

1,466 5x |

3,958 15x |

| Scalability on OCI (# GPUs) |

4 (per node) |

3,840 (per cluster) |

16,384 (per cluster) |

| Cluster network (in Gbps) |

N/A |

800 Gbps |

3,200 Gbps |

* NVIDIA L40SおよびNVIDIA H100の場合はFP16、NVIDIA A10の場合はFP8

OCIエンジニアは、品質を損なうことなく、ビデオを小規模で高速かつ低コストのバージョンに変換することを専門とするコンテンツ適応型ビデオ・ソリューションの世界的リーダーであるBeamrを支援し、わずか4か月でBeamrCloudを立ち上げました。OCIの使用について詳しく説明します:

「当社は、ベアメタル・インスタンスとNVIDIA L40S Tensor Core GPUを搭載したOCI AIインフラストラクチャを選択し、30%の効率的なビデオ・エンコーディングを実現しました。OCI上でBeamrCloudで処理されたビデオは、ストレージとネットワークの帯域幅消費を最大50%削減し、2xによるファイル転送を高速化し、エンドユーザーの生産性を向上させます。Beamr、OCIのお客様にビデオAIワークフローを提供し、ビデオの未来に備えます。」と、Beamr CloudのCEO、Sharon Carmel氏は述べています。

1つのNVIDIA H100 GPUと1つのNVIDIA A100 GPUを搭載したOCI Compute VM

まもなく、80GBのHBM3メモリーを搭載した単一のNVIDIA H100 GPUと、40GB/80GBのHBM2eメモリーを搭載したNVIDIA A100 GPUを搭載したコンピュート仮想マシン・シェイプを提供します。VM.GPU.H100.1シェイプには、NVMeドライブ容量の2×3.84TB、第4世代Intel Xeonプロセッサの13コアおよび246GBのシステム・メモリーも含まれており、様々なAIタスクに適しています。

この新製品は、小規模なワークロードとLLM推論のための効果的なプラットフォームを提供し、NVIDIA H100 GPUのTransformer EngineとFP8のサポートにより、大規模なモデルを定量化して単一のGPUで効率的に実行できます。

OCI上の他のNVIDIAアクセラレーテッド・シェイプと同様に、このシェイプはOCI Kubernetes Engine (OKE)およびNVIDIA Operator for Kubernetesと互換性があります。NVIDIA AI Enterpriseソフトウェア・プラットフォームの一部であるNVIDIA Inference Microservices (NIM)、およびNVIDIA GPU Catalog (NGC)のその他のコンテナ・パッケージは、OKEにシームレスにデプロイできます。

Altairは、シミュレーション、高性能コンピューティング、人工知能の融合を活用して、企業の意思決定を変革しています。OCIは、同社が高速GPUで使用するアプリケーションを設計するのに役立ちました。OCIの使用について詳しく説明します:

「NVIDIA H100およびA100 Tensor Core GPUを搭載したOracle Cloudのベアメタル・コンピュート、低レイテンシのOCI Supercluster、高性能ストレージにより、Altairの計算流体力学(CFD)および構造力学ソルバーのコスト・パフォーマンスが最大20%向上しました。Altair Unlimited仮想アプライアンスの仮想マシンでこれらのGPUを活用することを楽しみにしています。」と、Altair、データ管理および分析担当チーフ・エンジニア、Yeshwant Mummaneni氏は述べています。

NVIDIA GH200 Superchipを使用したOCI Compute

最後に、BM.GPU.GH200コンピュート・シェイプをお客様がテストできます。NVIDIA Grace Hopper SuperchipとNVIDIA NVLINK C2Cは、NVIDIA Grace CPUとHopper GPU間の高帯域幅のキャッシュコヒーレント900 GB/秒接続で、600GBを超えるアクセス可能なメモリを提供し、AIおよびHPCワークロードのパフォーマンスを最大10X向上させます。NVIDIA Graceアーキテクチャと今後のNVIDIA Grace Blackwell Superchipに関心のあるお客様は、OCIにコンタクトしてアクセスすることができます。

パートナーシップ

これらすべてのシェイプを、データ・サイエンスのパイプラインを加速し、生成AIの開発と導入を合理化するNVIDIA AI Enterprise、マイクロサービスと組み合わせることができます。Oracleは、コンテナをデプロイおよび管理するための複数のサービスを提供しています。これには、NVIDIAオペレータと互換性のあるOCI Kubernetes Engineが含まれます。

サマリーおよび次のステップ

Oracleは、ベア・メタル・インスタンスを提供する最初の主要なクラウド・プロバイダであり、OCI Superclusterで65,536のNVIDIA GPUに近日中に拡張すると同時に、OCIクラウド事業者とお客様の両方の管理性を向上させます。ベア・メタル・インスタンス、オフボックス仮想化、スケーラビリティを組み合わせることで、OCI AIインフラストラクチャはAI/MLワークロードにとって魅力的な選択肢となります。

オンラインのOCI AIインフラストラクチャにアクセスし、営業部門に問い合わせて詳細をご覧ください。